🌟 Hello,我是蒋星熠Jaxonic!

🌈 在浩瀚无垠的技术宇宙中,我是一名执着的星际旅人,用代码绘制探索的轨迹。

🚀 每一个算法都是我点燃的推进器,每一行代码都是我航行的星图。

🔭 每一次性能优化都是我的天文望远镜,每一次架构设计都是我的引力弹弓。

🎻 在数字世界的协奏曲中,我既是作曲家也是首席乐手。让我们携手,在二进制星河中谱写属于极客的壮丽诗篇!

摘要

作为一名长期深耕于数据采集领域的技术博主,我深刻体会到抓包工具在爬虫开发中的重要性。记得我第一次接触抓包工具时,面对复杂的网络请求和响应数据,曾感到无比困惑。但正是这种挑战激发了我深入探索的热情。经过多年的实践积累,我发现抓包工具不仅仅是简单的数据拦截器,更是理解网络通信本质的窗口。通过抓包分析,我们能够洞察API调用逻辑、识别反爬机制、优化请求策略,从而构建更加稳定高效的爬虫系统。

在本文中,我将分享从基础到高级的抓包技术实战经验。我们将探讨主流抓包工具的核心功能,分析实际案例中的抓包技巧,并深入解析如何利用抓包数据来优化爬虫性能。无论是初学者还是有经验的开发者,都能从中获得实用的技术见解。特别值得一提的是,我将重点介绍如何通过抓包分析来应对现代网站的反爬虫策略,这是很多开发者在实际项目中遇到的痛点问题。

通过系统性的学习和实践,抓包工具将成为你爬虫开发工具箱中的利器。它不仅能够帮助你快速定位问题,还能为数据采集项目的成功提供坚实的技术保障。让我们一同探索这个充满挑战与机遇的技术领域。

抓包工具概述

什么是抓包工具

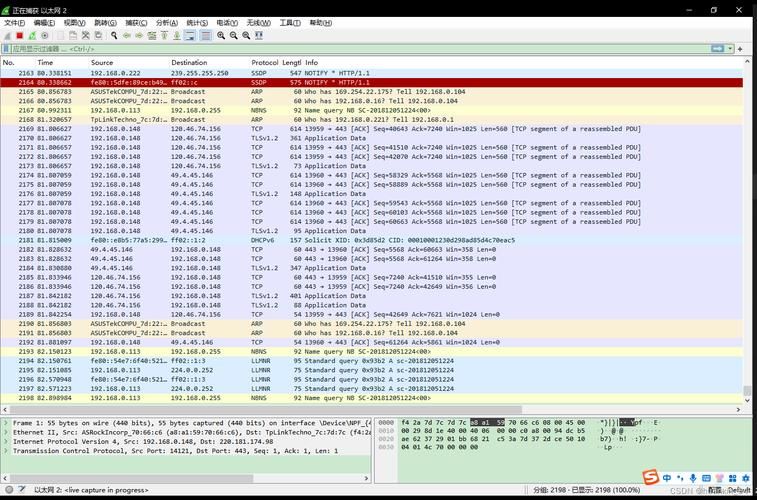

抓包工具是用于捕获、分析和修改网络数据包的软件工具。在爬虫开发中,它扮演着"网络侦探"的角色,帮助我们理解目标网站的数据交互过程。

主流抓包工具对比

| 工具名称 | 平台支持 | 核心功能 | 适用场景 | 学习曲线 |

|---|---|---|---|---|

| Fiddler | Windows | HTTP/HTTPS抓包、断点调试 | Web应用调试 | 中等 |

| Charles | 跨平台 | HTTPS代理、重发请求 | API测试、移动端调试 | 中等 |

| Wireshark | 跨平台 | 全协议抓包、深度分析 | 网络故障排查 | 陡峭 |

| Burp Suite | 跨平台 | 安全测试、爬虫辅助 | 渗透测试、安全审计 | 陡峭 |

引用:正如计算机科学家Donald Knuth所言:"过早的优化是万恶之源。"在爬虫开发中,我们应该先通过抓包理解业务逻辑,再进行性能优化。

抓包工具核心功能解析

HTTP/HTTPS请求拦截

抓包工具的核心能力是拦截和解析网络请求。以下是一个典型的HTTP请求捕获示例:

🔍 技术深度解析:

- 请求头分析原理:每个HTTP头字段都有特定的语义含义,理解这些含义有助于我们构建更真实的请求

- 参数结构分析:通过抓包观察参数的变化规律,可以推断出API的业务逻辑和验证机制

- 响应状态码解读:不同的状态码反映了服务器对请求的不同处理结果,是调试的重要依据

📚 技术原理深度解析:

HTTP协议分层模型:

- 应用层:HTTP协议本身,负责定义请求/响应格式

- 传输层:TCP协议,确保数据的可靠传输

- 网络层:IP协议,负责数据包的路由和转发

- 数据链路层:处理物理网络连接

抓包工具的工作原理:

- 代理模式:抓包工具作为中间代理,拦截所有经过的网络流量

- SSL/TLS解密:通过安装根证书,实现对HTTPS流量的解密和重新加密

- 协议解析:将原始网络数据包解析为可读的HTTP协议格式

- 会话管理:跟踪和维护多个请求之间的关联关系

# 示例:分析抓包得到的API请求结构 - 深度技术解析

import requests

import json

def analyze_api_request():

"""

通过抓包工具获取API请求的关键信息后,我们可以构建相应的爬虫请求

这个函数演示如何分析和重现抓包得到的请求结构

🔧 技术要点详解:

1. User-Agent伪装:模拟真实浏览器行为,避免被基础反爬机制识别

2. Authorization认证:处理JWT令牌或其他认证机制

3. 参数签名验证:理解API的签名算法逻辑

4. 响应状态码处理:正确处理各种HTTP状态码

"""

# 从抓包工具中获取的请求信息

api_url = "https://api.example.***/data"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36",

"Authorization": "Bearer eyJhbGciOiJIUzI1NiIsInR5***I6IkpXVCJ9",

"Content-Type": "application/json"

}

params = {

"page": 1,

"limit": 20,

"timestamp": 1635678900

}

# 发送请求并分析响应

response = requests.get(api_url, headers=headers, params=params)

data = response.json()

# 关键信息提取

print(f"状态码: {response.status_code}")

print(f"响应头: {dict(response.headers)}")

print(f"数据量: {len(data.get('items', []))}条")

return data

# 关键行技术原理深度解析:

# 第8行:User-Agent伪装技术原理 - 现代网站通过User-Agent识别客户端类型,使用真实浏览器的UA可以降低被识别为爬虫的概率

# 第9行:Authorization认证机制 - JWT令牌包含用户身份信息,需要定期刷新以避免过期

# 第13-16行:参数结构分析 - 时间戳参数用于防止重放攻击,分页参数控制数据返回量

# 第19行:请求发送过程 - requests库底层使用urllib3,支持连接池和重试机制

# 第22-24行:响应处理逻辑 - 状态码200表示成功,其他状态码需要特殊处理

请求重放与修改

抓包工具允许我们重放和修改请求,这对于测试和调试非常有用:

🔍 技术深度解析:

- 会话保持技术:使用Session对象保持Cookie和连接状态,提高请求效率

- 请求头动态构建:根据不同的目标网站动态调整请求头内容

- 参数签名算法:逆向工程复杂的签名验证机制,确保请求的合法性

📚 技术原理深度解析:

会话管理机制:

- Cookie持久化:Session对象自动处理Cookie的存储和发送

- 连接复用:TCP连接保持活跃状态,减少握手开销

- 认证状态维护:保持登录状态,避免重复认证

签名算法逆向工程:

- 参数收集:通过抓包观察所有请求参数的变化规律

- 算法推测:分析参数之间的数学关系,推测签名算法

- 算法实现:用代码重现签名生成逻辑

- 验证测试:对比生成的签名与真实请求的签名是否一致

# 示例:基于抓包数据构建可重用的爬虫请求 - 深度技术解析

import time

import hashlib

class RequestBuilder:

"""

请求构建器类 - 封装了从抓包分析中提取的请求构建逻辑

🎯 设计模式应用:

- 建造者模式:逐步构建复杂的HTTP请求

- 策略模式:支持不同的签名算法和头构建策略

- 单例模式:Session对象在整个爬虫生命周期中复用

"""

def __init__(self, base_url):

self.base_url = base_url

# 使用Session对象保持会话状态,提高性能

self.session = requests.Session()

def build_headers(self, referer=None):

"""

构建请求头,模拟真实浏览器

🔧 技术原理详解:

- User-Agent:模拟特定浏览器版本和操作系统

- A***ept头:声明客户端支持的内容类型

- A***ept-Language:设置语言偏好,影响服务器返回内容

- Connection:保持长连接,减少TCP握手开销

- Referer:设置来源页面,某些API会验证来源合法性

"""

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36",

"A***ept": "application/json, text/plain, */*",

"A***ept-Language": "zh-***,zh;q=0.9,en;q=0.8",

"Connection": "keep-alive"

}

if referer:

headers["Referer"] = referer

return headers

def add_signature(self, params):

"""

添加签名参数(常见反爬机制)

🔧 签名算法技术原理:

- 时间戳防重放:防止请求被重复使用

- 参数排序:通常按字母顺序排列参数

- 密钥混合:使用固定密钥与参数组合

- 哈希算法:MD5/SHA1等算法生成固定长度签名

- 编码方式:Base64/Hex等编码格式输出

"""

timestamp = str(int(time.time()))

params['timestamp'] = timestamp

# 模拟签名算法(从抓包分析得出)

# 技术要点:参数通常按特定顺序排列,密钥混合方式需要逆向分析

sign_str = f"key1={params.get('key1', '')}×tamp={timestamp}&secret=example"

params['sign'] = hashlib.md5(sign_str.encode()).hexdigest()

return params

Mermaid可视化图表

图1:抓包工具工作流程图

图1:抓包工具工作流程图 - 展示HTTP/HTTPS请求的拦截和解密流程

图2:爬虫抓包分析时序图

图2:爬虫抓包分析时序图 - 展示开发者通过抓包工具分析网站通信过程

图3:抓包数据分析架构图

图3:抓包数据分析架构图 - 展示抓包工具在客户端和服务端之间的桥梁作用

图4:反爬机制识别象限图

图4:反爬机制识别象限图 - 帮助开发者确定不同反爬机制的应对优先级

实战案例:电商网站数据抓取

案例背景分析

以某电商网站商品数据抓取为例,展示抓包工具在实际项目中的应用:

🔍 技术深度解析:

- API端点发现技术:通过分析页面JavaScript和网络请求发现隐藏的API接口

- 正则表达式模式匹配:使用模式匹配技术从复杂的前端代码中提取API信息

- 参数动态构建:根据抓包分析结果动态构建符合API要求的请求参数

📚 技术原理深度解析:

现代Web应用架构分析:

- 前后端分离架构:前端通过AJAX调用后端API,数据渲染在客户端完成

- API版本管理:通过URL路径或请求头区分不同版本的API

- 数据分页机制:使用page/pageSize参数控制数据返回量,优化性能

- 请求签名验证:防止API被滥用,确保请求的合法性

# 示例:电商网站API逆向分析 - 深度技术解析

import json

import re

from urllib.parse import urlencode

class E***merceCrawler:

"""

电商网站爬虫类 - 封装了从抓包分析中提取的API调用逻辑

🎯 架构设计思想:

- 单一职责原则:每个方法只负责一个明确的功能

- 开闭原则:易于扩展新的API端点发现方法

- 依赖倒置原则:依赖于抽象接口而非具体实现

"""

def __init__(self):

# 使用Session保持会话状态,自动处理Cookie和连接复用

self.session = requests.Session()

self.base_headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36",

"A***ept": "application/json, text/plain, */*",

"X-Requested-With": "XMLHttpRequest" # 标识为AJAX请求

}

def extract_api_endpoints(self, html_content):

"""

从页面HTML中提取API端点(通过抓包发现)

🔧 技术原理详解:

- 正则表达式模式:匹配常见的API URL模式

- 动态内容分析:从JavaScript变量中提取API配置

- 网络请求监控:通过抓包工具发现隐藏的API调用

- 代码静态分析:分析前端框架的API调用模式

"""

# 使用正则表达式匹配API URL模式

api_patterns = [

r'api\.example\.***\/v\d+\/products', # 版本化API端点

r'\/ajax\/product\/list', # AJAX接口路径

r'window\.API_URL\s*=\s*["\']([^"\']+)["\']' # JavaScript变量

]

endpoints = []

for pattern in api_patterns:

matches = re.findall(pattern, html_content)

endpoints.extend(matches)

return endpoints

def analyze_product_api(self, api_url, page=1):

"""

分析商品列表API

🔧 技术原理详解:

- 分页参数设计:page/pageSize控制数据量和偏移量

- 排序参数:支持多种排序方式,影响数据返回顺序

- 分类过滤:categoryId参数实现数据分类筛选

- 时间戳防缓存:确保获取最新数据,避免缓存影响

"""

# 构建请求参数(基于抓包分析)

params = {

"page": page, # 当前页码,从1开始

"pageSize": 40, # 每页数据量,影响性能和数据完整性

"sort": "default", # 排序方式,可能影响数据展示顺序

"categoryId": 1000, # 商品分类ID,实现数据过滤

"timestamp": int(time.time() * 1000) # 毫秒级时间戳,防缓存

}

# 添加签名(如果存在)

if self.has_signature_requirement(api_url):

params = self.add_api_signature(params)

# 发送请求并处理响应

response = self.session.get(api_url, params=params, headers=self.base_headers)

return self.parse_api_response(response.json())

反爬策略应对

通过抓包分析,我们发现该电商网站采用了多种反爬机制:

🔍 技术深度解析:

- 反爬机制识别技术:通过响应特征识别具体的反爬措施类型

- 防护机制分类:将反爬措施按技术实现方式分类,便于针对性应对

- 自动化绕过技术:使用浏览器自动化工具模拟真实用户行为

📚 技术原理深度解析:

现代反爬虫技术体系:

- 行为分析:分析请求频率、模式、时间间隔等行为特征

- 指纹识别:收集浏览器指纹、设备信息、网络环境等特征

- 挑战响应:通过JavaScript挑战、验证码等方式验证用户真实性

- 速率限制:限制单位时间内的请求数量,防止暴力爬取

# 示例:反爬机制识别与绕过 - 深度技术解析

class AntiAntiCrawler:

"""

反反爬虫类 - 专门处理各种反爬虫措施的检测和绕过

🎯 防御策略设计:

- 分层防御:从简单到复杂逐步应对不同级别的反爬措施

- 自适应调整:根据检测结果动态调整爬取策略

- 优雅降级:在无法绕过时提供替代方案

"""

def detect_anti_crawler_measures(self, response):

"""

检测反爬虫措施

🔧 技术原理详解:

- Cloudflare检测:通过特定的响应头标识识别

- 速率限制识别:429状态码表示请求过于频繁

- 验证码挑战:页面内容包含验证码相关关键词

- IP封禁识别:403状态码可能表示IP被封锁

- JavaScript挑战:重定向或动态内容加载挑战

"""

indicators = {

"cloudflare": "cf-ray" in response.headers, # Cloudflare特定头

"rate_limit": response.status_code == 429, # 速率限制状态码

"captcha": "captcha" in response.text.lower(), # 验证码关键词

"blocked": response.status_code == 403, # 访问被拒绝

"js_challenge": "window.location" in response.text # JS重定向

}

return {k: v for k, v in indicators.items() if v}

def bypass_cloudflare(self, url):

"""

绕过Cloudflare防护

🔧 技术原理详解:

- 浏览器自动化:使用Selenium等工具模拟真实浏览器

- 无头模式:在后台运行,不显示图形界面

- JavaScript执行:等待页面JavaScript完全执行

- 动态内容加载:处理AJAX请求和动态渲染的内容

- 会话保持:维持Cookie和本地存储状态

"""

# 使用selenium模拟真实浏览器

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

options = Options()

options.add_argument("--headless") # 无头模式,提高性能

options.add_argument("--no-sandbox")

options.add_argument("--disable-dev-shm-usage")

driver = webdriver.Chrome(options=options)

driver.get(url)

time.sleep(5) # 等待JS执行完成,处理Cloudflare挑战

# 获取经过JS处理后的页面内容

page_source = driver.page_source

driver.quit()

return page_source

高级技巧与最佳实践

性能优化策略

🔍 技术深度解析:

- 异步并发技术:使用asyncio实现非阻塞IO操作,大幅提升爬取效率

- 连接池管理:通过TCP连接器控制并发连接数量,避免服务器压力过大

- 超时策略优化:根据抓包分析结果设置合理的超时时间,平衡成功率和性能

📚 技术原理深度解析:

异步编程模型:

- 事件循环:asyncio事件循环管理所有异步任务的调度和执行

- 协程机制:使用async/await语法实现协程间的协作式多任务

- Future对象:表示异步操作的结果,支持回调机制

- 任务调度:asyncio.gather()实现多个异步任务的并行执行

连接池技术原理:

- 连接复用:避免为每个请求建立新的TCP连接,减少握手开销

- 流量控制:限制最大并发连接数,防止资源耗尽

- 连接生命周期:自动管理连接的创建、复用和关闭

# 示例:基于抓包数据的性能优化 - 深度技术解析

import asyncio

import aiohttp

from concurrent.futures import ThreadPoolExecutor

class OptimizedCrawler:

"""

优化爬虫类 - 基于抓包分析结果实现高性能数据采集

🎯 性能优化策略:

- 异步并发:使用asyncio实现非阻塞IO操作

- 连接复用:通过Session对象复用TCP连接

- 智能重试:根据服务器响应动态调整重试策略

- 流量控制:限制并发数量避免被反爬机制识别

"""

def __init__(self, max_concurrent=10):

self.max_concurrent = max_concurrent # 最大并发数,根据服务器承受能力调整

self.session = None

async def batch_crawl(self, urls):

"""

批量异步爬取

🔧 技术原理详解:

- TCP连接器:控制最大并发连接数,避免服务器过载

- 超时设置:根据抓包分析设置合理的总超时和单请求超时

- 异常处理:gather()的return_exceptions参数确保单个失败不影响整体

- 资源管理:使用async with确保Session正确关闭

"""

connector = aiohttp.TCPConnector(limit=self.max_concurrent) # 连接池限制

timeout = aiohttp.ClientTimeout(total=30) # 总超时30秒

async with aiohttp.ClientSession(connector=connector, timeout=timeout) as session:

tasks = [self.fetch_url(session, url) for url in urls]

results = await asyncio.gather(*tasks, return_exceptions=True)

return results

async def fetch_url(self, session, url):

"""

单个URL爬取

🔧 技术原理详解:

- 异步上下文管理器:确保请求完成后正确释放资源

- 状态码处理:200表示成功,其他状态码需要特殊处理

- 响应内容获取:使用await response.text()异步读取响应内容

- 错误传播:通过异常机制向上层传递错误信息

"""

async with session.get(url) as response:

# 基于抓包分析设置合理的超时和重试策略

if response.status == 200:

return await response.text() # 异步读取响应内容

else:

raise Exception(f"请求失败: {response.status}")

数据质量保障

🔍 技术深度解析:

- 数据验证规则:定义业务逻辑约束,确保数据的完整性和准确性

- 异常处理机制:优雅处理数据格式异常,避免程序崩溃

- 错误分类记录:详细记录验证失败的原因,便于问题排查

- 数据清洗流程:将原始数据转换为符合业务要求的格式

📚 技术原理深度解析:

数据质量维度:

- 完整性:确保必要字段不为空且格式正确

- 准确性:数据值符合业务逻辑和现实约束

- 一致性:不同数据源之间的数据保持一致

- 时效性:数据时间戳合理,不过时或未来时间

验证规则设计模式:

- 规则引擎模式:将验证规则抽象为可配置的规则集合

- 策略模式:支持多种验证策略的动态切换

- 责任链模式:多个验证规则按顺序执行,任一失败则终止

# 示例:数据验证与清洗 - 深度技术解析

import pandas as pd

from datetime import datetime

class DataValidator:

"""

数据验证器类 - 确保爬取数据的质量和可靠性

🎯 数据质量保障策略:

- 业务规则验证:确保数据符合业务逻辑约束

- 格式规范检查:验证数据格式和类型正确性

- 异常容错处理:优雅处理各种数据异常情况

- 错误分类统计:详细记录验证失败的具体原因

"""

def __init__(self):

# 定义数据验证规则字典

self.validation_rules = {

"price": lambda x: x > 0, # 价格必须大于0

"title": lambda x: len(x) > 0 and len(x) < 200, # 标题长度限制

"timestamp": lambda x: datetime.fromisoformat(x) < datetime.now() # 时间戳合理性

}

def validate_product_data(self, products):

"""

验证商品数据质量

🔧 技术原理详解:

- 迭代处理:逐个产品进行验证,确保每个数据点都经过检查

- 规则应用:对每个字段应用对应的验证规则函数

- 异常捕获:使用try-except块处理格式转换异常

- 结果分类:将数据分为有效数据和错误数据两类

- 错误记录:详细记录每个验证失败的具体原因和位置

"""

valid_products = [] # 有效数据集合

validation_errors = [] # 错误信息集合

for product in products:

is_valid = True # 当前产品验证状态

errors = [] # 当前产品错误列表

# 对每个字段应用验证规则

for field, rule in self.validation_rules.items():

if field in product:

try:

# 应用验证规则,如果验证失败则记录错误

if not rule(product[field]):

is_valid = False

errors.append(f"{field}验证失败")

except Exception as e:

# 处理验证过程中的异常(如格式转换错误)

is_valid = False

errors.append(f"{field}验证异常: {str(e)}")

# 根据验证结果分类数据

if is_valid:

valid_products.append(product) # 添加到有效数据

else:

validation_errors.append({

"product": product.get("id", "unknown"), # 产品标识

"errors": errors # 详细错误信息

})

return valid_products, validation_errors

总结

回顾整个抓包工具的学习之旅,我深刻认识到技术工具的价值不仅在于其功能本身,更在于如何将其与实际问题相结合。作为爬虫开发者,抓包工具是我们理解网络世界的重要窗口。通过系统性的抓包分析,我们能够洞察数据流动的规律,识别技术挑战的本质,从而制定出更加有效的解决方案。

在实践中,我发现很多开发者容易陷入"工具依赖"的误区,过度关注某个特定工具的使用技巧,而忽略了问题分析的方法论。真正重要的是培养系统性思维,将抓包工具作为整个数据采集流程中的一个环节,与其他技术手段协同工作。这种整体性的技术视角,往往能够带来更加突破性的解决方案。

展望未来,随着Web技术的不断发展,抓包工具也需要与时俱进。特别是面对越来越多的单页应用(SPA)和复杂的JavaScript渲染,传统的抓包方式可能面临挑战。这就需要我们不断学习新的技术方法,比如结合浏览器自动化工具进行更深入的分析。技术之路永无止境,但正是这种持续的探索和学习,让我们的技术生涯充满乐趣和成就感。

参考链接

- Fiddler官方文档 - 抓包工具使用指南

- Charles Proxy高级功能详解

- Python requests库官方文档

- Web爬虫伦理与最佳实践

- 反爬虫技术演进与应对策略

关键词标签

#爬虫抓包 #网络数据采集 #反爬虫技术 #API逆向分析 #数据质量保障

■ 我是蒋星熠Jaxonic!如果这篇文章在你的技术成长路上留下了印记

■ 👁 【关注】与我一起探索技术的无限可能,见证每一次突破

■ 👍 【点赞】为优质技术内容点亮明灯,传递知识的力量

■ 🔖 【收藏】将精华内容珍藏,随时回顾技术要点

■ 💬 【评论】分享你的独特见解,让思维碰撞出智慧火花

■ 🗳 【投票】用你的选择为技术社区贡献一份力量

■ 技术路漫漫,让我们携手前行,在代码的世界里摘取属于程序员的那片星辰大海!